网络页面蕴含着丰富的有价值数据,然而,在日常收集这些数据(如进行竞争分析或研究)时,可能会遇到一些挑战。

为了简化这一复杂任务,网络抓取工具应运而生。

相较于手动爬取,使用这些工具能显著节省时间和精力,从而让团队有更多精力专注于其他核心业务。不过,选择合适的工具至关重要,因为数据抓取过程中可能会遇到IP封禁、数据兼容性等风险。

本文特为各位介绍2024年十大高效网页数据抓取工具,以供参考。

网页抓取的定义是什么?

网页抓取,指的是从网站中提取各类数据(涵盖文本、图片、表格等)的过程,随后将这些数据转化为Excel、Word或数据库等便于使用的格式。此过程为众多企业及个人提供了极大的便利,使他们能够轻松收集数据,用于分析、竞争情报获取或实时信息更新。

为了迅速捕捉市场趋势与消费者行为的关键信息,众多公司纷纷采用网页抓取工具。这些工具能够自动化完成数据抓取任务,并配备有IP代理轮换、自动数据增强等功能,以有效规避网站的反爬措施,如验证码验证和速率限制。

尽管这些数据通常对公众开放,但企业往往会采取指纹识别、速率限制等手段来保护其数据安全。而网页抓取工具正是针对这些防御策略而设计的,旨在确保数据收集过程能够顺利进行,不受技术层面的阻碍。

2024年十大网页抓取工具(爬虫)

Apify

Apify是一个功能全面的网页抓取平台,专为开发者设计,助力他们构建、部署及监控网页抓取和浏览器自动化项目。它提供了一站式的数据提取方案,能够捕获互联网上几乎所有类型的公开数据。

Apify的独特魅力在于,它不仅支持用户创建个性化的抓取代理,还拥有一个庞大的预构建抓取模板库,供用户选择。

该平台尤其擅长于市场研究、情感分析以及潜在客户挖掘等任务。

核心功能:

- 集成的代理池,具备智能IP轮换和自动浏览器指纹模拟功能。

- 支持自定义cookies和headers,包含反机器人绕过工具包。

- 与Python和JavaScript无缝兼容,同时支持与Playwright、Puppeteer、Selenium和Scrapy等库的集成。

主要优势:

- 拥有超过1500个现成的网页抓取模板,极大提升了工作效率。

- 提供免费的网页抓取课程、学院资源及教程,助力用户快速上手。

- 具备可靠的数据提取能力,支持多种云服务和网络应用的集成。

- 因易用性和灵活性备受好评,且拥有丰富的文档支持。

不足之处:

- 客户支持反馈不够理想,有待提升。

- 任务并发数量有限,可能影响同时进行的数据提取作业效率。

价格方案:

- 高级初级计划起价为每月49美元。

- 提供免费试用版本,供用户测试平台功能。

Data Miner

DataMiner为Google Chrome浏览器用户推出了一款名为Data Scraper的网页抓取插件,该插件允许用户直接在浏览器中轻松抓取网页数据。DataMiner以简便性和高效性为核心,确保用户能够轻松地将抓取的数据导出为CSV文件。

主要功能:

- 自动化抓取:高效提取网页数据,减少手动操作。

- 自定义JavaScript脚本:支持用户编写脚本,以进一步提升数据抓取能力。

- 广泛兼容性:与所有域名兼容,确保在各种网站上都能顺利抓取数据。

- 额外功能:包括下载图片以及支持点击和滚动操作,以满足更广泛的数据抓取需求。

主要优点:

- 免费现场支持会议:为用户提供即时的帮助和指导。

- 用户友好界面:设计直观,易于导航和操作,降低使用门槛。

不足之处:

- 有限的电子邮件支持:可能导致高级故障排除时响应不够及时。

- Chrome专属:仅限于Chrome浏览器用户使用,限制了潜在用户群体。

- 额外培训费用:对于高级数据检索任务,可能需要支付额外的培训费用。

价格方案:

- 入门高级计划:起价每月19.99美元,适合需要更多功能和支持的用户。

- 免费计划:提供基本功能,满足基本使用需求。

Octoparse

Octoparse是一款直观易用的无代码网页抓取工具,专为技术与非技术用户量身定制,能够高效地将非结构化网页数据转化为结构化的数据集,适用于多种业务应用场景。

主要功能:

- 简易点击界面:操作简便,无需编程知识,人人皆可使用。

- 全面网站支持:轻松处理静态与动态网站,兼容AJAX、JavaScript及cookies。

- 复杂任务管理:有效管理登录、分页及从隐藏源代码中提取数据等复杂任务。

- 定时抓取:设定定时任务,实现特定时间点的数据收集。

- 云端操作:依托基于云的工具,确保24/7不间断运行。

- 智能助手:内置AI驱动的网页抓取助手,提升数据处理智能化水平。

主要优点:

- 适配数据密集型网站:支持无限滚动、自动循环等高级功能。

- 多语言支持:提供包括西班牙语、中文、法语及意大利语在内的广泛文档与支持。

- 多样化数据输出:支持将数据导出为Excel、API或CSV格式,满足多样化需求。

不足之处:

- 系统限制:目前不支持Linux系统。

- 学习曲线:对于初学者而言,部分功能可能稍显复杂。

价格方案:

- 免费计划:提供基础功能,满足基本需求。

- 高级计划:起价每月75美元,包含更多高级功能与支持。

ParseHub

ParseHub是一款功能丰富的网页抓取工具,其直观易用的界面使得从各类网站上提取数据变得轻而易举,无论是新手还是资深用户都能轻松上手。这款桌面应用程序尤其擅长处理动态网站(例如采用AJAX和JavaScript技术的网站)的数据抓取任务。

对于需要从登录后页面、地图、表格等复杂页面中提取数据的用户,ParseHub提供了强有力的支持。

主要功能:

- 跨页面数据提取:支持从多个页面抓取数据,并兼容AJAX和JavaScript动态内容。

- REST API集成:通过REST API实现高级数据收集,便于将抓取的数据整合至网页及移动应用中。

- 定时云存储:支持定时收集数据,并自动将数据存储至云端,确保数据安全与便捷访问。

- 大规模抓取优化:提供无限滚动、分页浏览及IP轮换功能,有效应对大规模数据抓取挑战。

- 精准数据定位:利用正则表达式及可自定义的头信息和cookies,精确锁定目标数据。

主要优点:

- 友好界面:无需编程基础,即可轻松上手。

- 免费试用:提供免费版本,适合初学者及小型项目测试。

- 强大抓取能力:能够处理复杂网站及交互元素,确保数据提取的完整性与准确性。

不足之处:

- 桌面应用限制:作为桌面应用程序,相较于云端解决方案,可能在访问便捷性上有所不足。

- 软件缺陷:已知的软件问题可能影响数据抓取过程的稳定性。

- 免费计划限制:免费版本在页面数量及使用时间上存在限制,处理大型项目时需考虑升级至付费计划。

价格方案:

- 免费计划:每个项目支持最多200页内容及40分钟的使用时长。

- 付费计划:起价为每月149美元,提供更多高级功能及更高的数据抓取限制,满足广泛的数据抓取需求。

Playwright

Playwright是微软倾力打造的一款备受赞誉的无头浏览器库,专为高效处理动态内容并模拟复杂的网页用户交互而生。其强大的功能集能够确保在不同环境下对浏览器实现无缝控制。

主要功能:

- 浏览器操作模拟:轻松实现导航、表单填写及数据提取等多种浏览器操作。

- 全面API支持:提供丰富的API,涵盖点击、输入及表单填写等核心功能。

- 模式灵活:同时支持有头和无头模式,满足多样化的浏览器自动化需求。

- 并行执行:支持跨多个浏览器并行运行,提升测试与抓取效率。

- 调试与报告:集成调试工具与内置报告功能,助力问题排查与结果分析。

- 自动等待:内置高级自动等待机制,有效管理异步任务,确保操作流畅。

主要优点:

- 全面自动化工具集:在同类工具中,Playwright提供了最为全面的自动化功能。

- 广泛兼容性:支持跨平台、跨浏览器及跨语言使用,极大提升了其应用灵活性。

- 微软维护:由微软官方维护,确保软件定期更新,稳定性与可靠性值得信赖。

- 一致API体验:无论使用何种编程语言,用户都能享受到一致的API使用体验。

不足之处:

- 初始设置复杂:对于初学者而言,Playwright的初始设置可能稍显复杂,需要一定的技术基础。

- 学习曲线陡峭:要充分发挥Playwright的全部功能,用户需要投入较多的时间与精力进行学习。

价格方案:

- 免费使用:Playwright完全免费,用户无需支付任何费用即可享受其强大的功能与服务。

ScraperAPI

ScraperAPI是一款功能强大的网页抓取工具,它极大地简化了从网页中提取HTML内容的流程,尤其擅长处理JavaScript渲染内容以及应对反抓取技术的挑战。

主要功能:

- 简易集成:仅需提供API密钥和URL,即可轻松接入。

- JavaScript渲染支持:完美处理JavaScript渲染的网页内容。

- 高级特性:包括JSON自动解析、智能代理轮换等强大功能。

- 自动化管理:自动处理CAPTCHAs、代理及浏览器特定配置。

- 抓取优化:支持自定义头信息、自动重试,提升抓取成功率。

- 地理定位代理:通过全球范围内的代理进行地理位置轮换,满足多样化需求。

- 无限带宽:确保高速、稳定的抓取体验。

- 高可用性:提供99.9%的在线时间保障及专业客服支持。

主要优点:

- 易用性:提供详尽的文档,支持多种编程语言,降低使用门槛。

- 高度可定制:灵活满足用户的特定需求,提升抓取效率。

- 代理支持:提供免费及高级代理选项,满足不同层次的需求。

不足之处:

- 功能限制:部分高级功能(如全球地理目标定位)仅在更高级别的订阅计划中提供。

- 技术门槛:要充分发挥其全部功能,可能需要一定的技术背景。

价格方案:

- 基础计划:每月29美元起,包含250,000次API调用及10个并发线程。

- 高级计划:每月49美元,享受无限带宽及更多高级功能。

ScrapingBee

ScrapingBee是一款专为开发人员设计的高级网页抓取API,旨在简化在线数据提取流程。通过提供用户友好的API接口,并处理代理和无头浏览器配置,开发人员可以专注于数据提取本身,而无需担心其他技术细节。ScrapingBee拥有庞大的代理池,能够有效绕过速率限制,降低被目标网站封锁的风险。

主要功能:

- 支持交互式网站:轻松应对需要执行JavaScript的网页。

- 反机器人检测:自动绕过各种反机器人检测机制,包括解决CAPTCHA问题。

- 自定义配置:支持可定制的头信息和cookies,满足个性化需求。

- 地理定位:提供针对特定数据本地化的地理定位功能。

- 全面数据提取:拦截XHR/AJAX请求,确保数据的完整提取。

- 灵活导出:支持HTML、JSON和XML等多种数据导出格式。

- 定时任务:提供定时抓取API调用功能,有效管理抓取任务。

主要优点:

- 成本效益:采用按成功请求付费的模式,确保用户成本效益最大化。

- 丰富文档:提供详尽的文档和博客文章,助力用户快速集成和故障排除。

- 简化配置:抓取端点配置简单,大幅降低设置复杂性。

- 功能全面:涵盖多样化的抓取需求,提供一站式解决方案。

- 广泛适用性:在各类网站上表现出色,满足广泛的数据提取需求。

不足之处:

- 速度非最优:相较于其他抓取API,ScrapingBee在速度方面可能不是最快的。

- 并发限制:并发限制较低,可能影响同时进行的多个抓取任务。

- 技术门槛:需要一定的技术知识才能充分发挥其功能和配置优势。

价格方案:

- 入门计划:每月49美元起,满足基本抓取需求。

- 免费试用期:提供有限的免费试用期,供用户进行测试和体验。

ScrapingBot

ScrapingBot是一款功能全面的网页抓取工具,它极大地简化了从各类平台(涵盖电商网站、搜索引擎及社交媒体)提取数据的流程。该工具能够直接从HTML页面中抓取数据,并将其转化为结构化的JSON格式,从而满足市场分析、价格监控等多种应用场景的需求。

主要功能:

- 针对性数据抓取:提供多个API接口,满足用户特定的数据抓取需求。

- 便捷的数据收集:用户只需输入URL,即可轻松收集所需数据。

- 代理集成:支持代理服务器集成,提高数据抓取的安全性和灵活性。

- 丰富的文档资源:提供详尽的文档和支持资源,助力用户快速上手。

- 兼容性强:通过API集成,与其他工具和服务实现无缝对接。

主要优点:

- 免费计划:提供包含每月API信用额度的免费使用计划,降低用户成本。

- 透明定价:采用清晰透明的定价策略,无任何隐藏费用。

- 高效性能:具备快速的数据抓取和传输能力,确保数据获取的时效性。

- 技术先进:支持JavaScript渲染和无头浏览技术,应对复杂网页结构。

- 广泛适用性:无论是简单还是复杂的数据需求,ScrapingBot都能提供满意的解决方案。

不足之处:

- 缺乏用户仪表板:未提供用户仪表板功能,无法直观跟踪使用统计和管理订阅信息。

- 支持渠道有限:主要通过电子邮件提供技术支持,可能无法满足部分用户的即时沟通需求。

价格方案:

- 免费使用:ScrapingBot提供基础功能的免费使用,满足用户的初步体验需求。

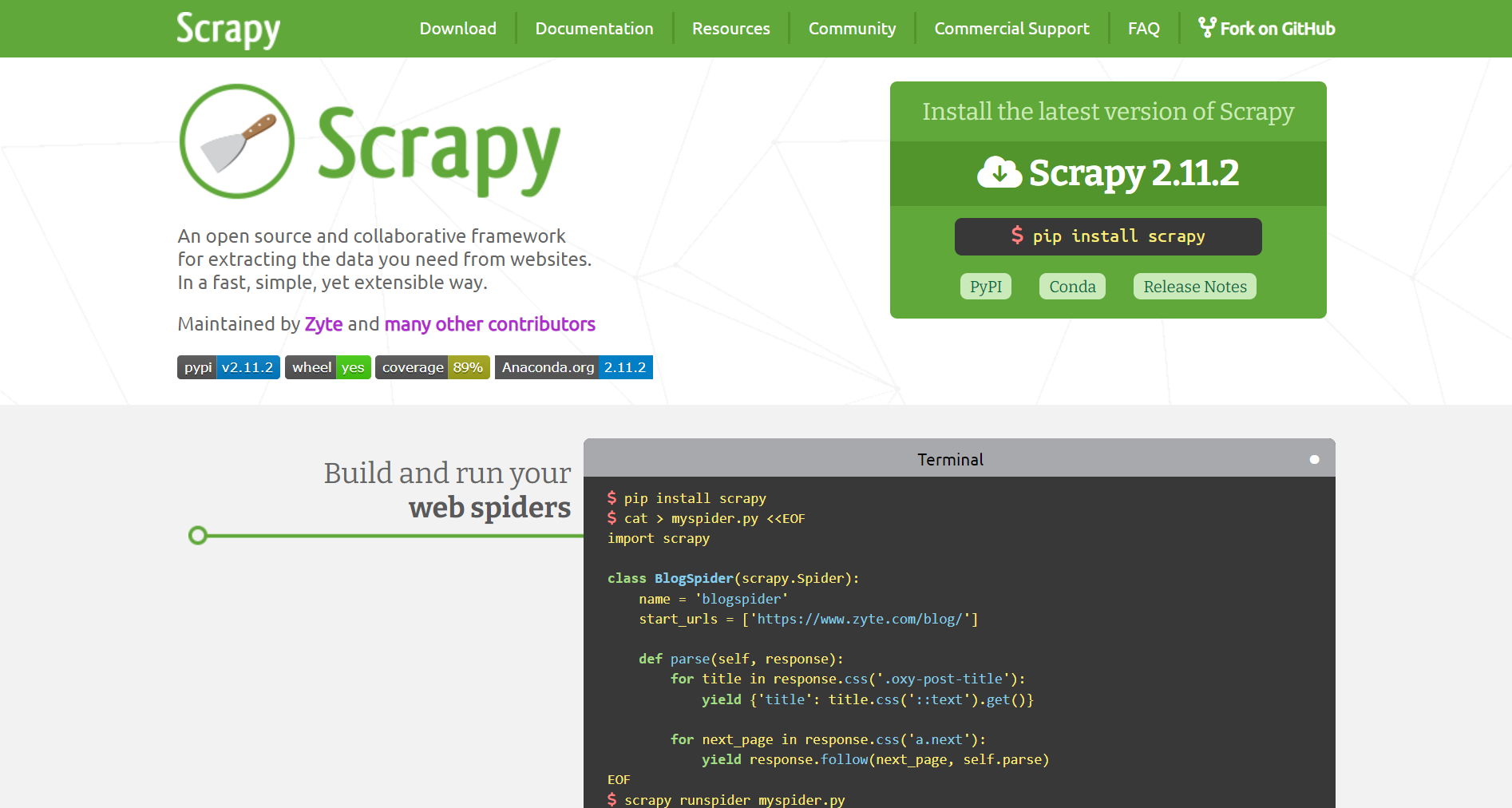

Scrapy

Scrapy是一个专为高速网页抓取与数据提取打造的开源Python框架,以其卓越的效率与灵活性在数据收集领域独树一帜,无论是简单还是复杂的任务都能轻松应对。

主要功能:

- 选择器支持:兼容CSS选择器和XPath表达式,方便用户灵活定位网页元素。

- 内置提取机制:提供丰富的数据提取工具,包括选择器与集成的HTML解析器,简化数据抓取流程。

- 中间件扩展:支持通过中间件进行功能扩展,轻松实现自定义需求,同时支持与多种代理及API的无缝集成。

主要优点:

- 可扩展性强:Scrapy框架设计灵活,能够轻松应对大规模抓取任务,满足用户的多样化需求。

- 高速抓取:凭借高效的爬取机制,Scrapy能够迅速完成网页数据的抓取工作,提升用户的工作效率。

不足之处:

- 技术门槛:Scrapy的使用需要一定的编程基础,特别是Python语言,这可能对非专业开发者构成一定的挑战。

- 浏览器自动化受限:Scrapy内置的浏览器自动化功能相对有限,对于需要处理交互式网页的任务,可能需要额外集成Splash等工具。

价格方案:

- 免费开源:Scrapy作为开源项目,用户可以免费使用其所有功能,无需支付任何费用。

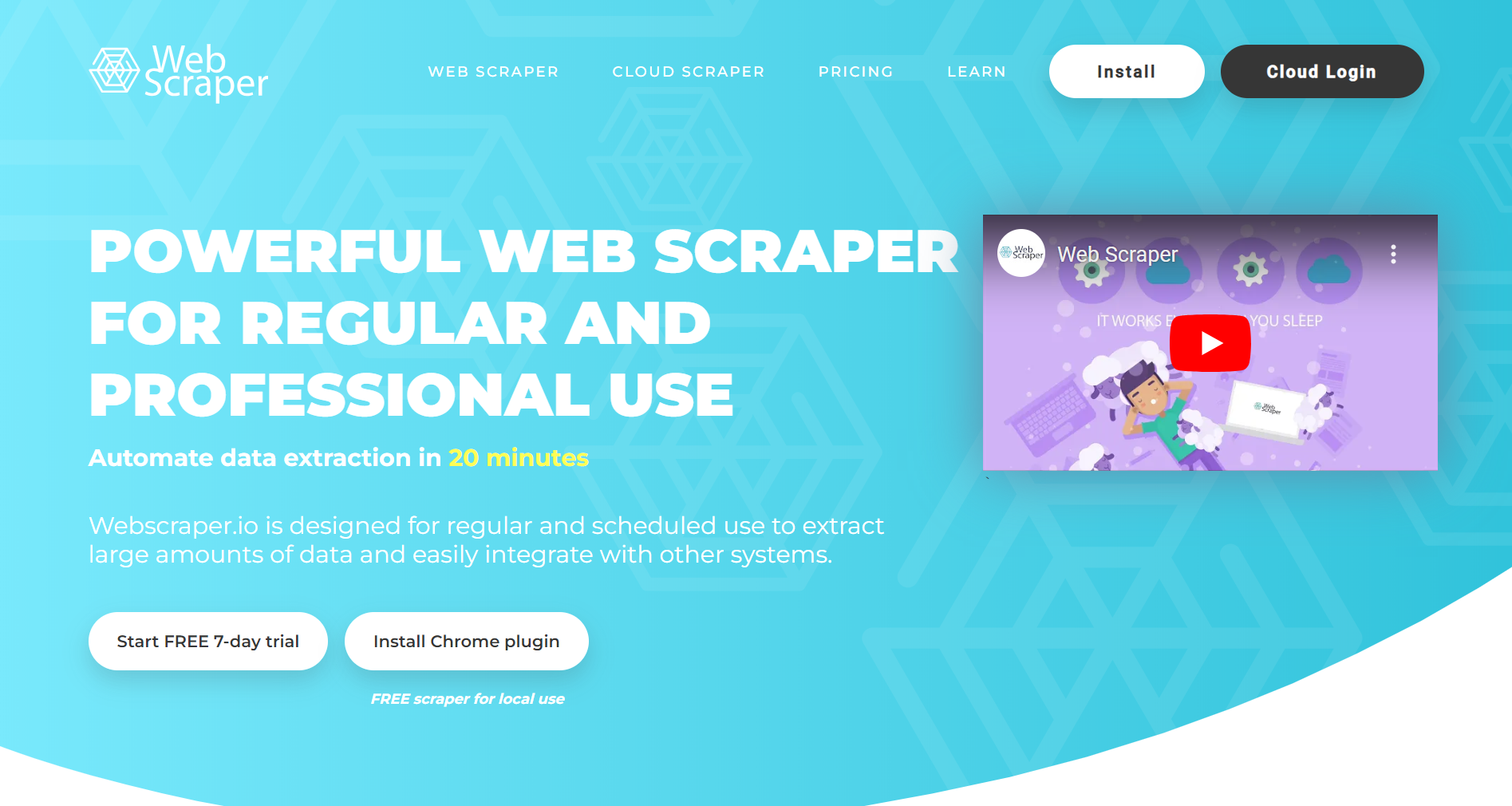

Web Scraper

Web Scraper是一款集云服务与Chrome浏览器扩展于一身的多功能数据提取工具,专为追求简单高效的数据抓取体验而设计。其直观易用的界面,使得即便是初学者也能轻松上手。无论是静态页面还是动态网站中的复杂分类与子分类数据,Web Scraper都能凭借其强大的抓取能力,帮助用户实现精准提取。

主要功能:

- 动态数据抓取:支持从动态网站中提取数据,轻松应对复杂分类与子分类的网页结构。

- 多样化导出:提供CSV、XLSX、JSON等多种数据导出格式,满足用户不同的数据处理需求。

- 任务调度器:内置抓取任务调度功能,实现数据提取过程的自动化管理。

- 代理集成:支持代理服务器的集成,有效管理IP轮换,降低被目标网站检测的风险。

- 手动选择功能:在浏览器中提供点击和选择功能,便于用户手动指定需要抓取的数据区域。

主要优点:

- 云端访问:基于云的服务模式,允许用户通过API远程访问并管理提取的数据。

- 直观界面:采用用户友好的界面设计,支持视觉化的HTML元素选择,降低操作难度。

- 适用广泛:适用于基本的抓取需求,功能直接且易于理解。

- 灵活执行:提供本地与云端两种抓取任务执行方式,满足不同场景下的使用需求。

不足之处:

- 并发限制:同时进行的抓取任务数量受限,可能影响处理效率。

- 成本较高:对于小规模用户而言,较高的成本可能构成一定的经济压力。

- 稳定性问题:部分用户反映存在响应时间慢和内部服务器错误的情况。

- 文档支持不足:缺乏全面的视频教程和高级支持选项,可能影响用户的学习和使用体验。

价格方案:

- 入门级高级计划:每月起价50美元,提供丰富的功能和资源支持。

- 免费试用期:提供有限的免费试用期限,供用户进行测试和体验。

汇总表

| 工具 | 主要功能 | 价格 |

|---|---|---|

| Apify | 全栈解决方案,预构建抓取器,支持市场研究 | 每月49美元起 |

| Data Miner | Chrome扩展程序,支持自定义JavaScript | 每月19.99美元起 |

| Octoparse | 点击界面,适用于动态网站 | 每月75美元起 |

| ParseHub | 从动态网站提取数据,支持REST API | 每月149美元起 |

| Playwright | 模拟浏览器互动,全面的API | 免费 |

| ScraperAPI | 简单的API集成,支持JavaScript页面 | 每月29美元起 |

| ScrapingBee | 处理JavaScript网站,反反爬措施 | 每月49美元起 |

ScrapingBot | 支持多种API,代理支持,易于API集成 | 免费 |

| Scrapy | 支持CSS选择器和XPath,内置HTML解析器 | 免费 |

| Web Scraper | 云服务,从动态网站提取数据 | 每月50美元起 |

在选择合适的网页抓取工具时,需综合考虑以下几个关键因素,以确保该工具能精准满足您的数据收集需求。

易用性

不同抓取工具的教程虽各有千秋,但关键在于其是否贴合您的技术背景和实际需求。有的工具专为Windows系统优化,而有的则更适配Mac OS。每个工具都为用户提供了不同的操作体验。因此,您应选择一款能让您操作自如、效率倍增的工具,并确保它能与您现有的系统和工作流程无缝对接,从而避免繁琐的学习过程。

定价透明度

成本是选择工具时不可忽视的一环。许多工具都提供免费的基础版本,而付费版本则解锁了更多高级功能。为确保您能在购买前充分评估其功能,建议选择定价清晰且提供免费试用期的工具。

支持的数据格式

大多数网页抓取任务都涉及处理常见的数据格式,如CSV,它因其广泛的适用性而备受青睐,尤其适合Microsoft Excel的忠实用户。

此外,一款出色的抓取工具还应支持JSON格式,因其简洁易读。同时,对于需要更复杂的数据库交互的场景,如XML和SQL等格式的支持也至关重要。

性能和灵活性

高效的抓取工具应具备快速提取数据的能力,并能通过API与网站进行顺畅交互,同时管理多个代理。选择开源工具将赋予您更高的灵活性,使您能够根据项目的独特需求定制抓取活动。

客户支持

可靠的客户支持是选择工具时的另一大考量因素。建议选择提供稳定、易访问的客户服务的工具,最好是全天候服务。当您遇到技术难题或需要优化抓取设置时,优质的客户支持将发挥举足轻重的作用。

浏览器指纹识别与应对

在使用网页抓取工具时,还需注意浏览器指纹识别这一因素。这种指纹类似于网站能识别的机器人特征,一旦被检测到,您的IP可能会被封禁,导致无法访问所需数据。

这时,BrowserScan等工具便派上了用场。它提供了一个机器人检测页面,用于检查这些机器人特征。如果您的脚本未通过BrowserScan的测试,它将显示不同的结果。您可以根据这些结果来优化您的自动化脚本,从而绕过检测,确保数据抓取的成功进行。

Comments

Post a Comment